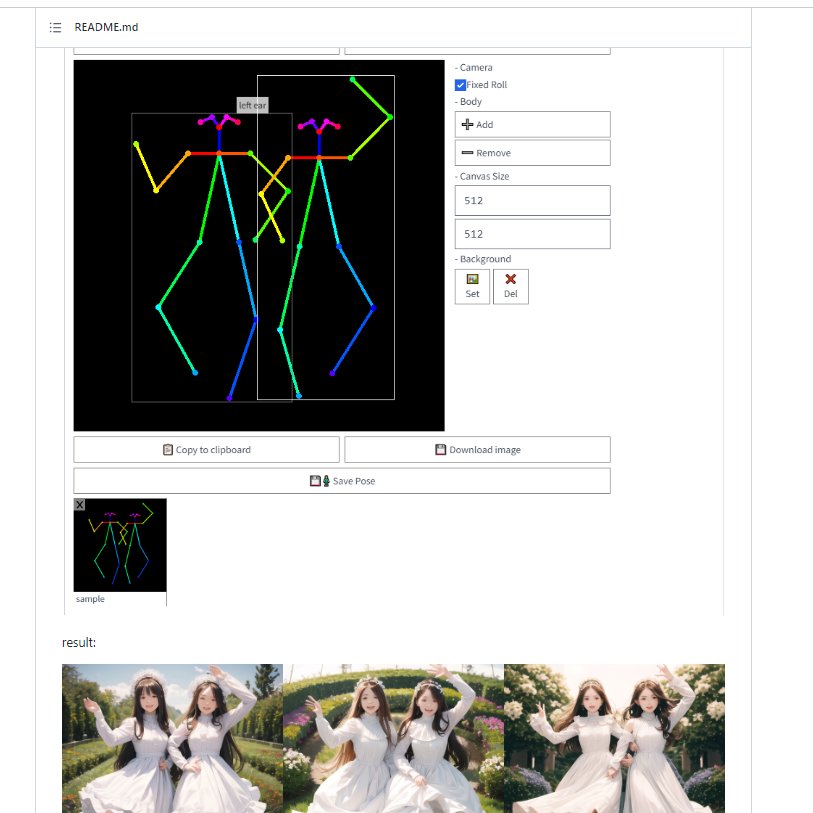

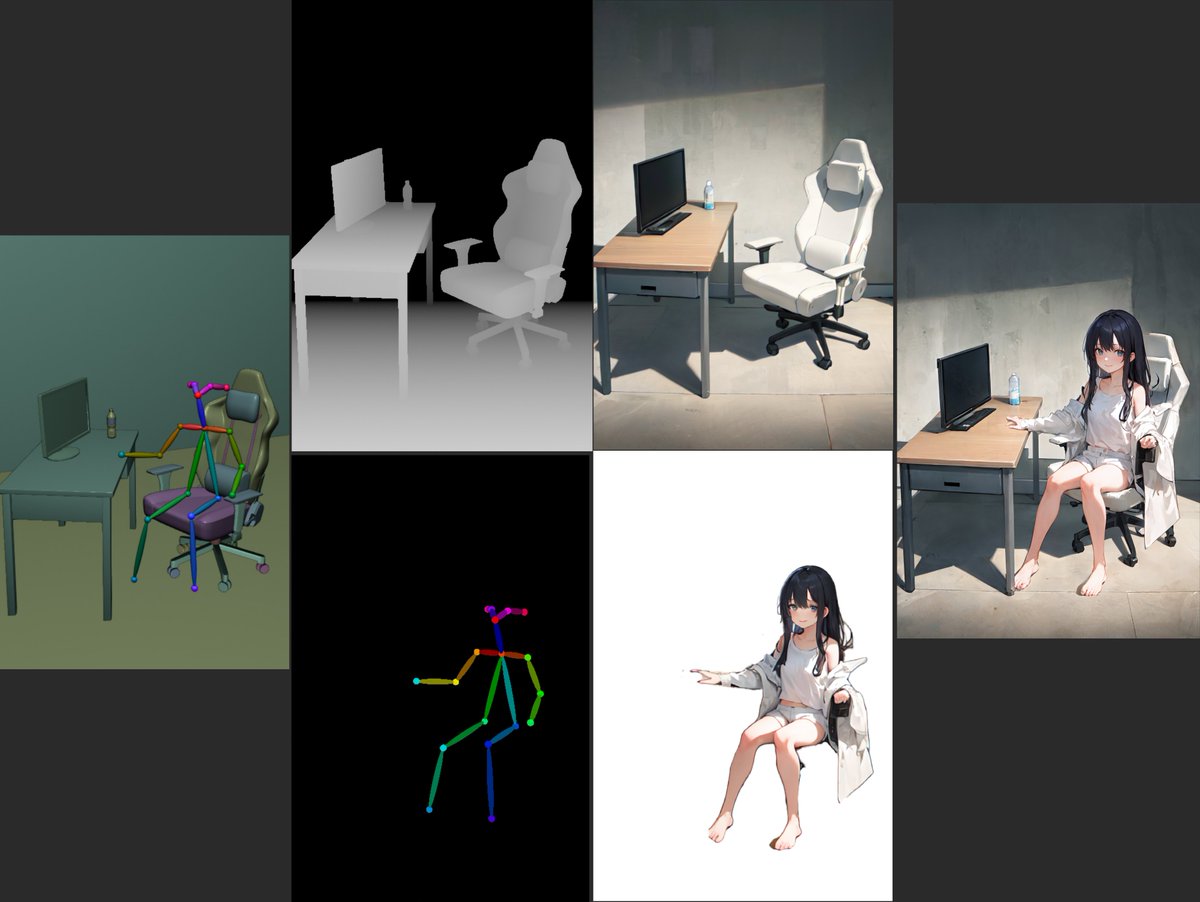

trevor baylis I read most of it. Curious where the line goes, and if controlNET created images would be closer? For example the ones created with Depth2Image or Pose2Image:

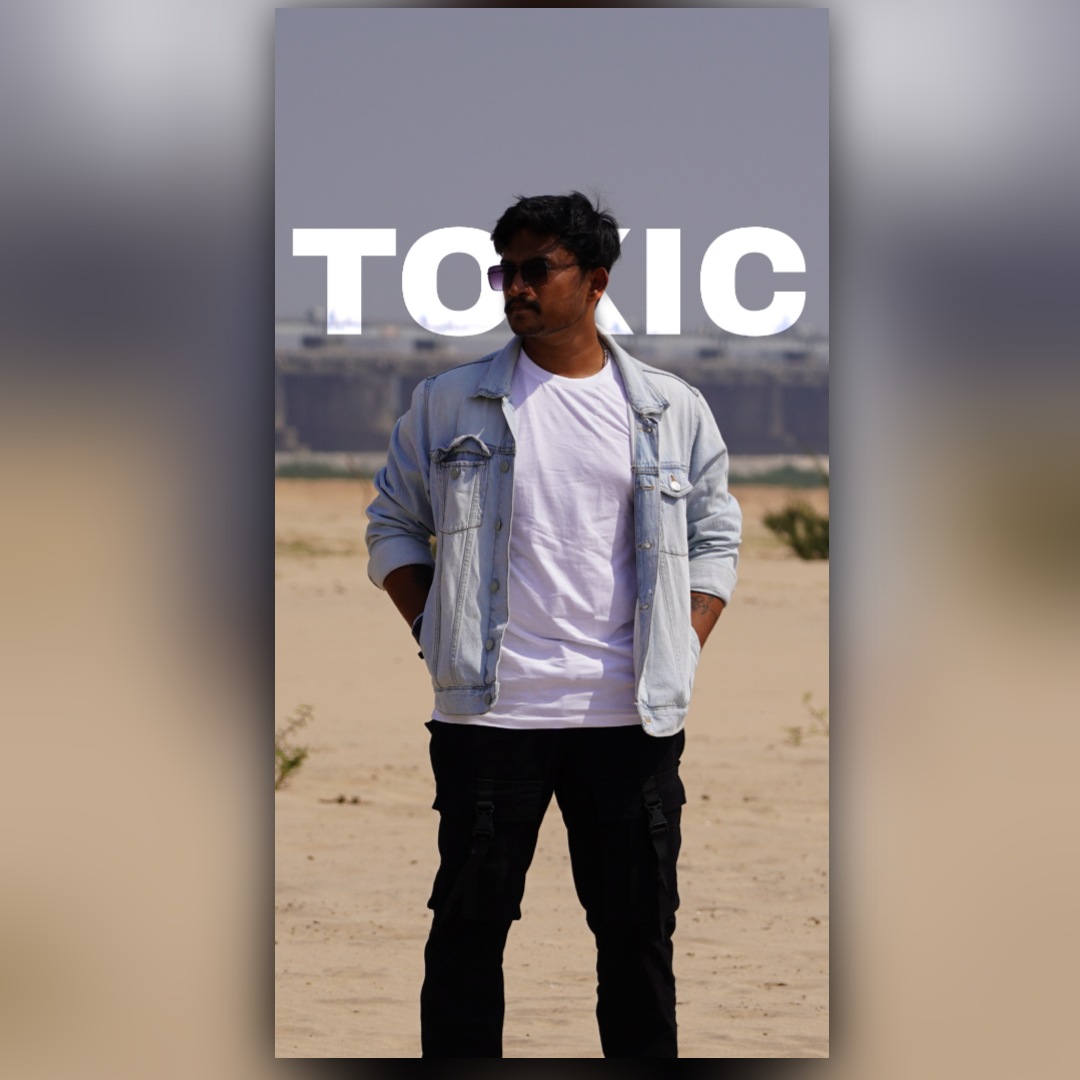

Don't be fooled, the person inside is an old man

#stablediffusion #midjourney #aiart #digitalart #nftart #waifudiffusion #AIイラスト #b3d #stableDiffusionWaifu #ControlNet #pose2Image #blender 3d #b3d #blender #blender 初心者 #gamedev #geometrynodes #proceduralart #3dmodeling

today prompts: chromatic aberration, cyberpunk color

#AIイラスト #AIイラスト 少女 #AIイラスト 好きさんと繋がりたい #cyberpunk #Chromatica #aberration #aipic #aiwaifus #pic2hd #candy2image #pose2image #text2image #aiportrait